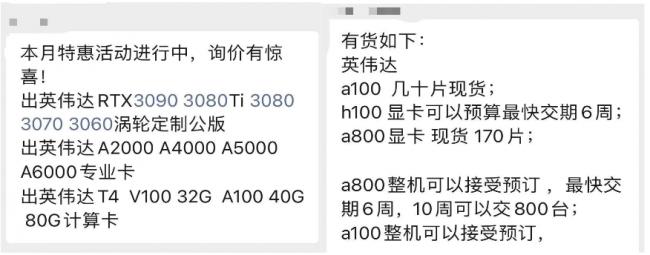

去年10月份以来,有人开始在垂直社群中喊话出售面临美国出口管制的英伟达高端芯片,声称A100、H100等都有办法搞到。

“少量H100芯片,有需要的私我。”

“有没有需要英伟达GPU A100,80G的?原厂原装,9片一箱。”

这些人往往备注直接——“英伟达芯片货源”,不论是八九十人的小群还是几百人的大群,他们都会冒个泡,不少芯片行业群中都收到了类似的消息。

按照这些卖家的说法,可以提供现货,但无法稳定供应量,期货一般8-14周交付,“40%定金,货到验货付尾款交付。”总会有人接茬问问价格、货源,能拿多少片,但成交与否不得而知,更多人只是观望。

知情人士称,这些卖家大多来自南方,拿货渠道隐秘,能把货从海外送到大陆的指定地点,但并不包售后。行业社群之外,拼多多、小红书甚至是闲鱼等平台上,也偶有“货源”出现。

今年10月17日,美国更新出口管制条例后,英伟达A800、H800、L40S等更多芯片面临禁售,地下市场的“尖儿货”开始洗牌,这些隐秘的卖家又开始在社交、电商平台现身,以二手的形式转售被禁的先进芯片。

“整机现货,欲购从速”。4万、13万、25万......不断变动并走高的价格,也引发从业者调侃:大概这是自去年10月禁售以来,我离天价芯片最近的一次。

芯片社群中有人喊话出售英伟达芯片

01

A100

电商平台一搜就有

去年10月,美国商务部发布出口管制条例,限制算力上限为4800以及带宽上限600 GB/s的AI芯片向中国出口,英伟达A100面临禁售,彼时正值全球人工智能行业发展的高峰时期。

A100是基于Ampere架构的GPU计算加速器,专为高性能计算、人工智能和机器学习等领域设计,拥有高达 6912 个 CUDA 核心和 40GB 的高速 HBM2 显存,是目前最强大的数据中心GPU之一。

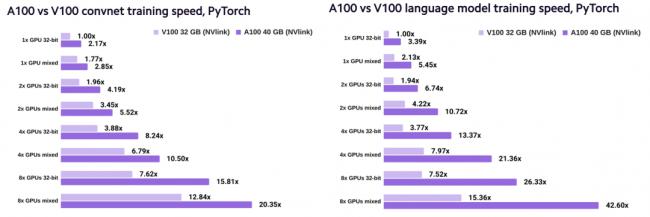

Lambda网站将A100与V100进行对比测试,结果显示,在卷积神经网络训练中,1块A100的训练速度是1块V100的2.2倍,使用混合精度时,前者则是后者的1.6倍;在语言模型训练中,1块A100的训练速度是1块V100的3.4倍;使用混合精度时,前者则是后者的2.6倍。

左图:A100与V100卷积神经网络训练速度对比 右图:A100与V100语言模型训练速度对比

这还只是用了A100 40GB版本,80GB版本的A100 HBM2位宽达5120bit,显存带宽达1935 GB/s,能支持更快的训练速度和更大模型容量,处理大规模并行计算的应用程序不在话下。

有从业者直白表示:“你做出来的是人工智能,还是人工智障,全靠背后的算力支持,直接决定胜负。”

此次切断供应直接影响到大数据、云计算、自动驾驶、计算机等多个领域,很多企业被迫延迟甚至砍掉了开发计划。

为了规避出口管制,英伟达针对性地向中国市场推出A800和H800芯片,以满足中概互联企业的算力需求,但如果需要采购A100和H100这种在管制清单上的产品,就只能通过非官方渠道。

今年4月以来,社交、电商甚至二手电商平台上,开始有人报价A100芯片,也有一些帖子暗示自己有少量A100货源,价值不低于一台宝马。

社交平台上A100芯片售卖、租赁的帖子

根据芯潮IC的跟踪观察,今年2月份,A100即开始在国内以非官方渠道的形式流通,价格大概在4万人民币左右,最低还卖过2万多,随着5月份中概互联网企业卷起大模型热潮,A100价格一路走高,最高成交价接近25万元,浮动范围极大。

有业内人士透露:“一般一台服务器上需要装配8张显卡”,按最高成交价25万元来算,一台服务器整机价格接近200万元。

人工智能产业对算力渴望,让更高端的芯片也加入了非官方流通之列,到6月份,H100的报价在上述渠道也多了起来。不少芯片社群里头顶“货源”的潜水销售们,也将自己的昵称悄悄改为“H100芯片货源”。

公开资料显示,H100相较于A100,16位推理速度上提升3.5倍,训练速度上提升2.3倍,如果用服务器集群运算的方式,训练速度更是能提高到9倍,自发布起就受到追捧。

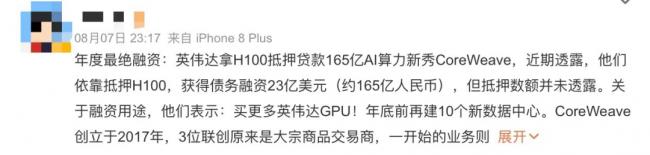

亚马逊CEO Adam Selipsky就曾表示:“H100是最先进的……即使对于AWS来说也很难获得。”而这话,就连OpenAI、Meta、微软这些科技巨鳄也非常想说。据江湖流传的小道消息,H100甚至可以作为一种“敲门砖”,初创公司以此找基金拿抵押贷款。

CoreWeave抵押H100获得债务融资

据外媒报道,9月份,英伟达在日本的销售合作公司把H100价格调涨16%,达544万日元(26.5万元人民币)。

有价无市,一哄而上,作为市场主流,这两款芯片俨然是AI算力“硬通货”,但因为出口管制,只能在社交、电商平台等非官方渠道流通。

在具体的询价过程中,有的店主表示“有单卡,模组和整机”,但更多的手上只有少量的单片散货:“现货32张,就看谁手快了”,更有店主大方表示,这些产品没有保修或支持服务,但被问及发货地和货源时,回答会含糊一些,“

海外发货,大陆交付,但可以送到指定地点。”

有购买者向芯潮IC透露,“确有不少人在销售英伟达 GPU,但能否获得真正的A100、H100,在收到货之前还是难以确认,毕竟也曾有人花了两万美金,却买到了翻新货。”

02

iPhone水客到H100水客

业内皆知,A100、A800、H100这三款芯片是禁令颁布以来市场主流。

一般认为:火爆程度上H100>A100>A800,A800主要面向中国市场,是A100的“阉割版”,H100比A100还要更高阶一点。此外还有一款号称是“H100阉割版”的H800。

A100上文已介绍过,这里不再赘述。A800是英伟达在遵守2022年出口管制标准的前提下,为中国地区开发的A100“平替”。从官方公布的参数来看,A800主要是将NVLink的互联带宽由A100的600GB/s降至了400GB/s,其他参数与A100基本一致。互联带宽也就是我们常说的传输速率,直接影响着芯片输入和输出的能力,对训练大模型十分重要。

Jefferies全球证券首席策略官Christopher Wood在研报中指出,英伟达为避开美国2022年9月输中禁令所打造的“A800”系列芯片,最近几月对中国的销量非常庞大。

H100发布于今年3月,是一款基于4nm工艺,拥有800亿个晶体管、18432个核心的 GPU芯片。针对中国市场,英伟达也推出了特供版H800,据外媒报道,H800 的芯片间数据传输速度大概是 H100 的一半,阿里巴巴、百度的云部门已采用H800芯片。

一位不愿透露姓名的渠道商表示:“现在整个市场主流就是H100,很多公司报价高达50万,但实际成交价格在32万左右,不过确实很难拿到货,9月份的出货量也只有3000片左右。”

至于支付定金,在这位渠道商看来,“市面上传订货要付50%定金,比正规渠道高出了差不多30%,真实货源面前,支付多少定金已经不重要了。”

而与H100的火热形成对比,年初崭露头角,年中走向高点的A100已基本“退烧”。电子元器件渠道商觉S向芯潮IC透露,“A100最热的时候,哪怕你手里只有三五片,人家都会拿过去拼凑,但采购潮在6月份就基本结束了,现在需求基本饱和,至于A800芯片,现在谁拿到基本都会砸在手里。”

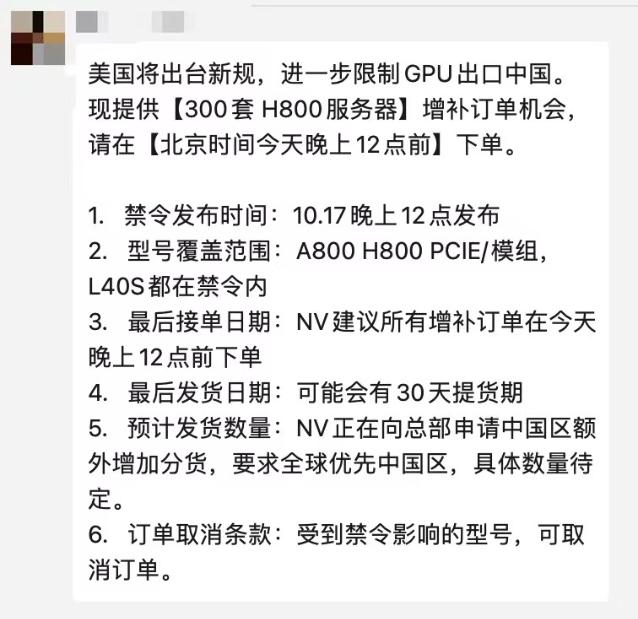

10月17日,美国商务部颁布新一轮出口管制条款,针对中国市场的平替版本英伟达 A800 和 H800面临禁售,L40S甚至RTX 4090都被推上了风口浪尖,黑市“尖货”价格又一次戏剧性上涨。有消息称,当日晚间预定的H800 GPU整机单价已高达245万元,较一个月前的期货预订价195万元已高出25%。

社交平台上关于A800/H800售卖租赁的帖子

不过这次,很多国内厂商都提前接到了消息,预先完成了囤货。国内一家服务器厂商的内部人士表示,他们十月初就接到了这个(禁售)消息,目前已经囤了足够量,不过未来还是有很大压力。

出口管制新规发布前某供应商通知增补订单 受访人供图,仅供参考

综合市场的信息,应用软件开发商、初创公司、研究机构和游戏玩家是这些芯片的主要采购者,也可能涉及一些敏感机构和实体 。

有需求就会有供给,一条隐秘的地下交易链条也逐渐成型——供应商们采购芯片的方式主要有二:一是在英伟达向美国大型企业大量发货后,抢购市场上的剩余库存;二是通过在印度、台湾、新加坡等地本地注册的公司进行进口。

知情人士表示:“对于大型企业来说,拿货一般有固定的渠道,而且消息都是高层间直接勾兑,走货量大,中间商作用较弱。”

那市面上持有少量显卡的卖家又是如何搞到货呢?

有渠道商透露,其实显卡大概是两个巴掌大小,由于每个国家把控严格度不一,如果揣在包里,报关时把它报成普通电子设备,流通就成为可能,好比当年水客运输iPhone。也有人从服务器上下功夫,“一般服务器都是类似于茶海大小,海外发到我们这边都会拆散,但里面的东西基本上不会损坏。”不过大家心里也清楚,走中小型中间商渠道,风险会很高,虽然买个几片、定金也交了,一旦被查基本只能认栽。

渠道商仓库A100、H100装箱实拍 受访人供图,仅供参考

总的来说,国内真正能勾兑这类交易的人屈指可数,就连坊间传得神乎其神的华强北,也有很多办不到的事。中间商就算想分一杯羹,也多会因为繁琐复杂的过程验证而退出——客户会质疑货物真假,是不是拆机件,能不能确保100%原厂出货;供货端更是会仔细盘问买家、用途、是不是真的有能力付钱。

也有渠道商曾试图在这种产品上赚一笔,但最终尝尽苦头,有感而发:“做一单几万美金,或者二十万美金的生意尚且很复杂很小心,更何况这是一笔上千万美金的订单,是很难做到的。”

风险因素众多,除了产品来源非官方、去向不确认,市面上还会有不少翻新货,运气够差的话,你手里拿到的根本就不是A100。知情人士称,“拿到芯片后必须得组装起来才知道真假好坏,有点儿像开盲盒”,“如果向某些比较正规的公司签合同购买,都至少有1-3年的质保,单从外面的渠道购买是基本不靠谱的,保修售后也不要想了。”

据介绍,运输过程中磕碰、泡水比较常见,还有卖家把已经不流通的 A100 40GB芯片,改成80GB来卖,上当的也大有人在。

03

所有人都被产能“卡脖子”

H100还没成为历史,抢卡又开始了新的轮回,甚至消费级的RTX 4090一下成为风暴中心。10月17日之后的短短三日,RTX 4090的价格像坐了火箭,冲上4万不说,在华强北线下和淘宝第三方店铺均已断货。

“4090是被性能密度拖下水的,实际上4090目前也没有人真的拿来做AI。”有业内人士向芯潮IC表示,RTX 4090是目前游戏玩家能够买到的最顶尖的游戏显卡,AI大模型训练等商业需求,RTX 4090虽在理论上可以串联满足(很少有人会这么做),更多还是满足个人需求当个游戏卡。

令所有人都没想到的是,本来有30天窗口期的禁令竟提前生效——24日晚间,英伟达发布公告称新出口限制改为立即生效,但炒得正热的RTX 4090却不在禁售名单中。

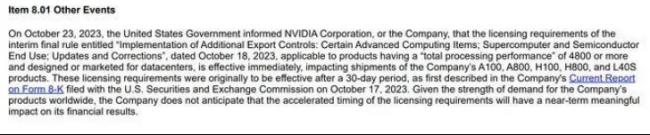

根据英伟达周二提交给SEC的文件,美国商务部10月23日通知该公司,上周(10月17日)公布的出口限制改为立即生效,影响适用于“总处理性能”为4800或更高,并为数据中心设计或销售的产品,即 A100、A800、H100、H800和 L40S 的出货。

英伟达发布公告截图 来源:英伟达官网

从禁售到不受影响,价格也就暴涨暴跌,疯狂囤货的黄牛被双手暴击,但事情一直在动态翻转。

日前,又有消息称,多家英伟达合作显卡品牌确认RTX 4090系列将于11月17日之后在中国大陆全面禁售。尽管真实性无从考证,4090似乎有着自己的“真香定律”。

从A100、H100、A800,再到H800、 L40S......历史宛若一个轮回,套住了深扎其中的玩家,不论是身为制造商的台积电、联电,还是像英伟达、AMD等人工智能计算公司,更不必说华为、寒武纪、摩尔线程、壁仞等诸多被禁令“点名高挂”的中国大陆企业,都随这一场场的风波浮浮沉沉。

问题症结在哪儿?除了天天讲的禁令,制造端的产能更为关键。

从根源上看,英伟达有多少货取决于台积电的CoWoS产能

。CoWoS 是台积电的一种“2.5D”封装技术,其中多个有源硅芯片集成在无源硅中介层上,是最流行的 GPU 和 AI 加速器封装技术,英伟达 A100、H100芯片均用台积电CoWoS 先进封装。

2023年,ChatGPT风靡全球,AI芯片需求应声大涨,这大大超过了英伟达的预估。一位有丰富半导体制造经验的知情人士表示,“原本英伟达 2022年在台积电预订的产能是3万片,今年3月ChatGPT爆火后,又紧急追加了5000片,再后来又追加了1万片,最终在台积电的订单共有4.5万片。”

4.5万是个什么概念呢?

2022年,台积电CoWoS年产7万片,今年受ChatGPT爆火的影响,台积电计划将年产能提升到14万片,而这其中单单英伟达一家就已经占据了超三成。对英伟达来说,台积电出多少就买多少,但同时还有AMD也要出货,谷歌自研的TPU也在翘首盼望,这14万片的产能早就被瓜分了个精光。

据业内人士介绍,CoWoS 所需中介层因关键制程复杂、高精度设备交期拉长而供不应求,目前产能严重受限,正处在艰难爬坡过程中。这也意味着哪怕是英伟达这样的大客户,想追加更多都是不可能的。

所以,现在A100、A800、H100、H800等芯片如此紧缺,问题症结在于台积电CoWoS产能的不足。上述知情人士表示,这个问题有望在明年第二季度解决,那时产能大量释放,

明年台积电CoWoS有望达到30万片。

想象一个场景,如果明年产能不再紧缺,在美国、日本、新加坡,这几款芯片要多少有多少,需求饱和,流入中国市场只是时间早晚。现在全球缺货加上中国被限,芯片的价差特别高,但产能跟上后,价差自然会变小,千金囤货的故事终会告一段落。

那么,产能何时才能跟上?眼下的问题有该怎么解决呢?

该知情人士认为:“明年应该是见真章的一年,预计明年下半年ChatGPT的落地场景会明确下来。”

届时,H100在训练端的需求可能会到顶,但推理端场景有很多,需求增长无穷无尽。现如今,Meta、Microsoft等国外大厂做训练和推理基本都用H100,部分小厂可能为了性价比选择训练用H100,推理用A100。但其实,推理端并不是非高端芯片不可,今年8月,英伟达“曲线救国”,给出了绕过CoWoS封装的解决方案——L40S。

这是一款专为搭建数据中心设计的 GPU芯片,在具有数十亿参数和多种模态的生成式AI工作负载下,L40S的18176个CUDA核心可提供近5倍于A100的单精度浮点(FP32)性能,相较于A100推理性能提升1.2倍,训练性能提升1.7倍,从而加速复杂计算和数据密集型分析。对于全球而言,在CoWoS封装产能有限, H100供给不足的当下,L40S 可谓一场及时雨,但现在也遭遇了“一纸禁令”。

禁令的波及不仅体现在先进芯片产品的直接销售上,也体现在先进工艺的制造代工上,寒武纪,摩尔线程、壁仞已经无法在台积电流片,而只能转向大陆晶圆厂。据了解,目前中芯南方厂今年、甚至明年上半年的产能已经排满,相关需求大概明年下半年才能做。

“GPU现在良率很低,必须要有足够的产能才会去跑GPU,但等到明年下半年中芯南方产能释放,其实一定程度上已经失去了先机。”